Kollaps!

Claude 3.5, Anti-Hype und Habsburg-KI

du liest den tech-newsletter von gregor schmalzried. find me on linkedin!

Kollaps!

1 MEIN NEUER FREUND CLAUDE

Ich habe seit etwa sieben Wochen keinen Newsletter mehr veröffentlichen können (Zeitgründe! Buh!) – und deshalb hier direkt die wichtigste Neuigkeit von allen:

Claude 3.5 Sonnet von Anthropic ist die beste AI, mit der ich je gearbeitet habe, und hat ChatGPT in meinem Alltag fast komplett ersetzt.

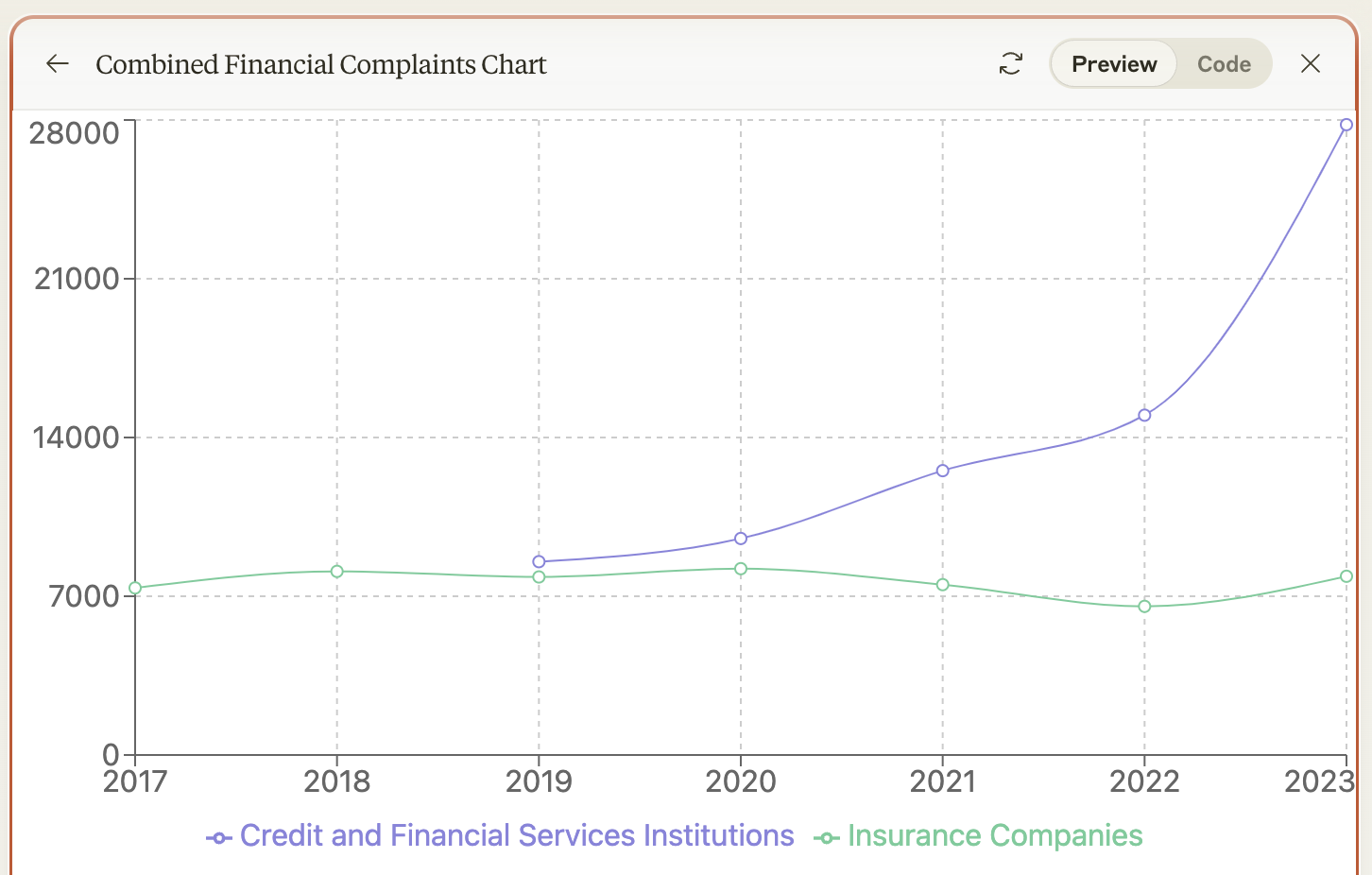

Hier ist einer der Cases, den ich mit Claude Anfang Juli für einen Workshop vorbereitet habe:

einfache Screenshots von Diagrammen aus dem Jahresbericht der Bafin (aka dem langweiligsten Dokument, das ich finden konnte) analysieren und zu einem neuen Diagramm zusammenfassen:

Anhand dieser Daten eine simple lineare Vorhersage für die Jahre 2024 und 2025 aufstellen:

Ein interaktives Tool bauen, um diese Prognosen entsprechend eines Faktors anzupassen

(die Annahme hier ist, dass ein Schrumpfen der Wirtschaft zu mehr Beschwerden führen würde. Natürlich ist das Szenario ausgedacht und willkürlich, es geht nur darum, wie leicht man mit Claude ein solches Modell bauen kann.)

All das kann Claude 3.5 mit Bordmitteln. Es braucht nur kurze Text-Prompts.

Claude 3.5 ist außerdem deutlich besser beim Arbeiten mit komplexen Texten und Sachverhalten. Hier sind die Fortschritte subtiler – sie lassen sich schlecht in einem Screenshot zusammenzufassen. Aber wenn man länger damit arbeitet, sind sie obvious.

Und zu guter Letzt: die “große” Version von Claude 3.5 ist immer noch unveröffentlicht – bislang haben wir nur die “mittelgroße” Sonnet-Version zum Ausprobieren.

Ein bisschen was geht da also noch.

Oder doch nicht?

2 KOLLAPS!

Denn was ich gerade mit Claude erlebe, sollte eigentlich gar nicht möglich sein.

Zumindest nicht laut der Berichterstattung um eine Untersuchung, die vor zwei Wochen in Nature veröffentlicht wurde:

Die These – simpel zusammengefasst:

“AI-Modelle wie GPT-4 und Claude 3.5 benötigen fürs Training echte menschliche Daten. Wenn man sie aber stattdessen mit Daten trainiert, die selbst AI-generiert sind, vergiftet sich das Modell dadurch selbst. Es entsteht eine Art AI-Inzucht, an deren Ende das Modell nur noch Blödsinn von sich gibt.”

Im Paper selbst heißt es:

“We find that indiscriminate use of model-generated content in training causes irreversible defects in the resulting models”

Das ist offensichtlich ein Problem, denn GPT-4 und Co. beziehen ihre Daten zu einem großen Teil aus dem Internet, und das ist mittlerweile voll von synthetischen Texten. ChatGPT-Websites und -Profile fluten das Web. Wenn die AI jetzt davon lernt... Ist sie dazu verdammt, zu kollabieren?

So berichtet z.B. Heise über die Untersuchung:

Diese Erzählung ist nicht neu. Schon letztes Jahr wurde über “Model Collapse” diskutiert. Denn, so heißt aus den Mündern einiger “Technologie-Kritiker”: Der Kollaps habe schon längst begonnen. Synthetische Daten hätten die großen KI-Modelle, die KI würde dümmer, sie hätten schon ihren Zenit überschritten. “Model collapse has already begun”. “Habsburg-KI”. Usw.

Soweit die Story.

3 DOCH KEIN KOLLAPS!

Wenn diese Story wahr wäre, dann hätte der Beginn dieser Kolumne nie existieren können. Denn Claude 3.5, genau wie GPT-4o, genau wie Llama 3.1, genau wie alle anderen großen AI-Modelle, ist längst mit synthetischen Daten trainiert worden.

Über das neue Llama-Modell von Meta z.B. wissen wir dank seines Papers genau, wie AI-generierte Daten das Modell nicht etwa verschlechtert haben, sondern verbessert. Das neue Llama-Modell hat im Trainingsprozess immer wieder selbst Daten generiert, diese überprüft und anhand der Ergebnisse in seine Parameter eingearbeitet. Llamas Mehrsprachigkeit, seine mathematischen und multimodalen Fähigkeiten… alle wären ohne synthetische Daten nicht so gut.

Was ist also bei der Untersuchung in Nature schiefgegangen?

Blicken wir nochmal auf den Schlüsselsatz: “We find that indiscriminate use of model-generated content in training causes irreversible defects in the resulting models.”

Indiscriminate. Undifferenziert.

Die Forscher in dem Versuch trainierten das LLM mit willkürlichen Datensätzen, die willkürlich generiert wurden. Sie nutzten auch jede Trainingsrunde, um die Daten der vorangegangenen Runde wieder rauszuschmeißen.

Anders gesagt: Sie taten alles, um den Kollaps des Modells absichtlich herbeizuführen. Als hätten sie beim Anschluss einer Deckenleuchte den Außenleiter mit der Erdung verbunden – Kurzschluss!

In der Praxis werden synthetische Daten beim Training rigoros gefiltert und auf sehr interessante Weise eingesetzt (mehr zu den technischen Details hier und hier). Zum Collapse kommt es dabei nicht. Wenn man keinen Kurzschluss will, schließt man halt nicht zwei Kabel aneinander, die einen Kurzschluss verursacheen.

4 DIE SEHNSUCHT NACH DEM KOLLAPS

Ich schreibe diesen Text an einem Kollaps-Tag.

Tech-Aktien stürzen gerade ein (oder fallen zumindest auf den Stand von vor 2 bis 3 Monaten) und es gibt immer mehr Zweifel daran, ob die KI-Revolution schon in den nächsten Jahren die gigantischen Versprechen einlösen kann, die von McKinsey & Co gemacht wurden.

Ist AI overhyped?

Es ist absolut möglich, dass die astronomischen Bewertungen von Nvidia und anderen Tech-Konzernen sich auf Dauer nicht halten können. Dass die Implementierung von LLMs auf Unternehmensebene eben doch komplizierter ist als von vielen angenommen.

Ich persönlich habe in meiner Arbeit über das letzte Jahr immer wieder den Eindruck gewonnen, dass viele Entscheider nur wenig davon verstehen, was LLMs und andere Modelle wirklich im Hier und Heute leisten können.

Das Gerede über unmittelbar bevorstehende AGI und Massenarbeitslosigkeit macht die Sache nicht einfacher. Das ist Hype ohne Basis in der Realität.

Aber Gerede darüber, dass LLMs nutzlos und am Kollabieren wären, ist Anti-Hype ohne Basis in der Realität.

Die Geschichte von Model Collapse klingt interessant, ist einfach zu verstehen und enthält auch noch eine ironische Pointe, weil die KI sich selbst vergiftet.. Kein Wunder, dass sie ständig ausgepackt wird. Es ist eine super Story!

Aber eben eine rein theoretische.

In der praktischen Realität kollabiert überhaupt nichts. LLMs erreichen ständig neue Benchmarks, werden besser, günstiger und schneller. Sie ermöglichen fantastische Möglichkeiten für diejenigen, die bereit sind, Zeit und Kreativität zu investieren.

Haben sich Venture Capitals und Big Tech trotzdem finanziell zu viel von ihnen versprochen?

Das kann absolut sein. Wir haben die Ergebnisse der großen Investitionen (GPT-5) noch nicht gesehen und können deshalb unmöglich jetzt schon wissen, ob die ganzen Milliarden sich gelohnt haben.

Was wir wissen: Claude 3.5 existiert heute schon. Zum Glück.

Außerdem

Portfolio

In den letzten Folgen des KI-Podcast: Open Source-Modelle, Urlaubsplanung mit LLMs, Robotics und 1 Jahr KI-Podcast: ardaudiothek.de open.spotify.com

Mode ohne Menschen: Mango setzt auf KI-generierte Models. br.de

Malbücher und Abenteuergeschichten: So geht KI für Kinder. br.de

Programme zur Erkennung von KI-Texten bleiben fehlerhaft. br.de

Aleph Alpha: Wie die deutsche KI-Hoffnung ins Straucheln geriet. br.de

LLMs

Google Search Ranks AI Spam Above Original Reporting in News Results. wired.com

People cannot distinguish GPT-4 from a human in a Turing test. arxiv.org

Konzept für eine profitable Content-Spam-Maschine – möglich gemacht von GPT4o mini. batchmon.com

AI companions can effectively reduce loneliness, comparable to human interaction. hbs.edu

Schöner technologiekritischer Text über das Outsourcen unserer Gedanken an LLMs. theconvivialsociety.substack.com

AI und Arbeit

Benedict Evans über die Challenges von AI-Implementierung in großen Unternehmen. Passt zur Blasenfrage. ben-evans.com

AI Is Already Taking Jobs in the Video Game Industry. wired.com

“State of the Cloud 2024”: Umfassender Report über den Cloudmarkt in der AI-Revolution. bvp.com

Hollywood’s video game performers announced they would go on strike Thursday, throwing part of the entertainment industry into another work stoppage after talks for a new contract with major game studios broke down over artificial intelligence protections. apnews.com

Über die Chancen kleiner Teams mit AI-Know-How (mein Lieblingsthema). implications.com

AI Doesn’t Kill Jobs? Tell That to Freelancers. wsj.com

AI und Bild/Video/Audio

Der bislang beste AI-Kurzfilm, den ich gesehen habe, weil er die Traumartigkeit von AI-Bildern sehr gut nutzt. twitter.com

Meta is tagging real photos as ‘Made with AI,’ say photographers. techcrunch.com

Black Forest Labs ist noch unter dem Radar, aber könnte bald als neue deutsche KI-Hoffnung wichtig werden. Der von ihnen entwickelte Bild-Generator Flux ist fantastisch! the-decoder.de

AI und alles andere

Meta bietet aus regulatorischen Gründen wenige seiner AI-Lösungen auch in Europa an. Damit liegen sie im Trend, denn bei Apple, Google etc werden ähnliche Entscheidungen getroffen. Meanwhile haben (außer Mistral) bisher keine europäischen LLM-Initiativen beeindruckt. Sieht nicht gut aus. reuters.com (Meta) wired.com (Europa)

Insider bei Amazon über die Struggles von Amazon und Alexa im AI-Zeitalter. fortune.com

Are you 80% angry and 2% sad? Why ‘emotional AI’ is fraught with problems. theguardian.com

“Figma disables its AI design feature that appeared to be ripping off Apple's weather app.” Wer ein AI-Tool mit Confidence verkaufen will, sollte einen Plagiats-Checker mit einbauen. techcrunch.com

San Francisco hat jetzt selbstfahrende Taxis, die völlig normal herumfahren und genutzt werden. theverge.com

Most ChatGPT users think AI models have conscious experiences. livescience.com

Die AI-Suchmaschine Perplexity geht Partnerschaften mit verschiedenen Medienhäusern ein, u.a. dem Spiegel. Perplexity ist ein interessantes Produkt, aber leicht disruptierbar. Wenn es funktioniert, können OpenAI, Google und Apple einfach das Gleiche bauen. Wenn es nicht funktioniert (weil zu teuer oder unattraktiv), dann gehen sie pleite. Es würde mich wundern, wenn Perplexity die nächsten drei Jahre übersteht. theverge.com (allgemein) medium.com (Spiegel)

Content

Influencers aren’t getting famous like they used to. glamour.com

Substack, die Newsletterplattform über die auch dieser Newsletter läuft, hat jetzt einen deutschen Mitarbeiter und eine Deutschlandstrategie. omr.com

Anscheinend sind “Sonnencreme-Truther” die neueste Verschwörungstheorie der Stunde? cbsnews.com

Die Disney-Krise: Children used to grow up watching Mickey Mouse. Now they're all on YouTube. businessinsider.com

Marcus Bösch über Brat Summer und Meme-Wahlkampf. substack.com

Tech

YouTuber bauen zunehmend eigene Streaming-Plattformen. Besonders spannend (wenn auch in diesem Artikel nicht genannt): Der Doku-orientierte Service Nebula. omr.com

Drei Viertel der deutschen Firmen nutzen noch Faxgeräte. spiegel.de

Wie Standortdaten die Sicherheit Deutschlands gefährden. br.de

Fun

Der Gen Z-Brokkoli-Haarschnitt. gq.com

Two ChatGPTs can't stop saying goodbye. youtube.com

What Happens When You Reach The Bottom Of TikTok. youtube.com

I am using AI to automatically drop hats outside my window onto New Yorkers. dropofahat.zone

Magdalena Bay - Image. youtube.com

🤯,