Ein Computer für deinen Computer

Wie Generative AI ihre größten Schwächen überwindet

du liest gregor schmalzrieds newsletter über ai, tech und media.

ich bin freier journalist, berater, speaker und host von der ki-podcast (ARD)

Ein Computer für deinen Computer

1 JAKOBS FEHLER

Vor ungefähr acht Jahren erklärte mir Jakob (Name v.d.R. geändert), warum sich AirPods nie durchsetzen würden. Die Klangqualität sei viel schlechter, die eingebauten Mikrofone ein Witz, und vor allem: Warum würde irgendwer eine Technologie, die ganz ohne regelmäßiges Aufladen funktionierte, durch eine mit Akku ersetzen?

Jakob war ein Kommilitone in meinem Masterstudiengang, und obwohl wir zwei Semester lang in einigen Kursen zusammen waren, ist dieses Gespräch das einzige zwischen uns, an das ich mich explizit erinnere. Vermutlich, weil er über keine andere Sache mit so viel Inbrunst reden konnte wie hierüber.

Natürlich hatte Jakob mit all seinen Punkten recht. Kabellose Kopfhörer waren in vielerlei Hinsicht schlechter als ihre kabelgebundenen Vorgänger. Trotzdem haben sie gewonnen. Kabelgebundene Kopfhörer existieren zwar immer noch, aber sie zu benutzen ist nonkonformistisch, teilweise sogar ein Fashion Statement. Die AirPods, mit ihren nervigen Akkus, ihrer schlechten Soundqualität und ihrem Hang zum Verlorenwerden, sind einfach beliebter.

Die Geschichte der Technologie ist voll mit neuen Erfindungen, die schlechter waren als das, was bisher existierte. Edisons Glühlampen waren teurer und dunkler als die bislang gebräuchlichen Gaslampen. Die ersten Automobile waren von Pannen geplagt und von schwer erhältlichem Benzin abhängig. Die ersten Flachbild-Fernseher litten unter verwaschenen Farben und eingebrannten Sendelogos.

Viele dieser Probleme wurden mit der Zeit gelöst. Aber nicht alle. AirPods haben sich teilweise verbessert, aber aufladen und verlieren tut man sie immer noch. Auch das Tippen auf dem iPhone ist für geübte Tastatur-Tipper immer noch nicht so easy wie das Tippen an einer echten Tastatur (wie es das Blackberry hatte).

Wir nehmen oft an, eine Erfindung müsste in jeder Hinsicht eine Verbesserung gegenüber des Status Quo sein, um sich durchzusetzen. Wenn nicht, dann halten Menschen wie Jakob mit sensiblen Einwänden dagegen: Braucht es das wirklich? Ist das wirklich besser als das, was wir schon haben?

Aber wenn eine Erfindung in einer Sache besonders gut ist… Dann kann sie es schaffen, ihre ganze Kategorie neu zu definieren. Wenn die Stärken stark genug sind, können sich unsere Prioritäten weit genug verschieben, dass uns manche Schwächen gar nicht mehr stören. Ich bin froh, dass ich mit meinen AirPods easy zwischen verschiedenen Geräten hin und her wechseln kann, ohne dabei ein Kabel in die Hand nehmen zu müssen. Ich bin froh, dass mein iPhone keinen Platz an eine Tastatur verschwenden muss. Auch wenn Jakob technisch gesehen recht hatte.

2 WIE VIEL DENKEN IST ZU VIEL?

All das führt uns zu Generative AI. Und zu dem Paper “The Illusion of Thinking”, mit dem Apples Forschungsabteilung in den letzten zwei Wochen einen medialen Feuersturm losgetreten hat.

“The Illusion of Thinking” beschäftigt sich mit “Reasoning”-Sprachmodellen wie OpenAIs o3 und DeepSeeks R1. Diese unterscheiden sich von klassischen Sprachmodellen wie GPT-4o dadurch, dass sie eine Art “inneren Monolog” haben, mit dem sie besser planen, strukturieren und in vielen Fällen genauere Antworten geben können (mehr dazu z.B. hier).

Seit ihrer ersten Veröffentlichung haben Reasoning-Modelle in Sachen AI-Fortschritt konstant den Ton angegeben. Weil die besten Reasoning-Modelle meist noch hinter Paywalls sitzen, sind sie in der öffentlichen Wahrnehmung kaum angekommen (in meinen Beratungs- oder Schulungs-Jobs ist die Unterscheidung für die meisten in der Regel neu). Dabei sind sie die wichtigste Kategorie von Sprachmodell zur Zeit: Sie können verlässlicher für komplexe Aufgaben eingesetzt werden und gehören fest zum Alltag der meisten AI-Nerds hinzu.

Deshalb ist es auch so lustig, wegen dieses Apple-Papers auf einmal Clickbait-Posts wie diese hier zu sehen – die in den letzten zwei Wochen Social Media bestimmt haben:

Was steht also drin in diesem Paper? Nun, es beschäftigt sich größtenteils mit Logikrätseln, etwa dem beliebten Türme von Hanoi.

Dabei zeigen die Forscher, dass Reasoning-Modelle diese Rätsel in der Regel lösen können, solange die Rätsel relativ einfach sind. Aber je komplexer die Rätsel werden, d.h. je mehr Steinchen oder Gegenstände im Spiel sind, desto öfter kommt es zu Fehlern.

(Ein ähnliches Phänomen zeigt sich, wenn man ChatGPT Schach spielen lässt: Hier verwechselt das Modell Figuren, schlägt verbotene Züge vor und verliert sogar gegen Schachcomputer aus den 70ern.)

Das sind die Schwächen moderner Sprachmodelle: Sehr komplexe Aufgaben können sie von alleine nicht lösen. Die Forscher von Apple haben hierfür interessante Beispiele gefunden.

Nur sind diese Schwächen eben kein “fundamentales Hindernis”, oder ein “Knockout-Schlag für LLMs”, wie es die Clickbait-Posts der letzten zwei Wochen suggerieren. Auch dass die Apple-Forscher sich von den Erkenntnissen “überrascht” zeigen (Ableitungen des Wortes “surprise” finden sich fünfmal in dem Paper), ist eigenartig. Denn nichts hieran ist wirklich dramatisch neu.

Große Sprachmodelle können von alleine keine enorm komplexen Probleme lösen.

Okay.

Und AirPods haben keine Kabel.

Das iPhone hat keine Tastatur.

Ein Automobil braucht Benzin.

Das ist die Ironie der Stunde: Ausgerechnet Apple, das Unternehmen, das sich nie zu schade war, scheinbar schwächere Produkte mit neuen Stärken zu etablieren, kritisiert gerade AI-Sprachmodelle dafür, dass sie schlechter seien als klassische Software.

Dabei sollten sie nie klassische Software sein.

3 BESSER ALS EXCEL, SCHLECHTER ALS EXCEL

Es ist völlig klar, dass Sprachmodelle anders funktionieren als klassische Computerprogramme.

Wenn Excel in 49 von 50 Fällen die richtige Antwort ausgeben würde, und in 1 von 50 Fällen die falsche, dann wäre Excel kaputt.

Bei ChatGPT ist das manchmal eine normale Trefferquote.

Dass Sprachmodelle trotzdem hilfreich sind, liegt einmal daran, dass es für viele Aufgaben in Ordnung ist, mit solchen Fehlerquoten zu arbeiten (Beispiele hierfür finden sich in den letzten drei Jahren dieses Newsletters sowieso jede Woche in Der KI-Podcast). Es liegt aber zunehmend auch daran, dass Sprachmodelle eben nicht mehr auf sich allein gestellt sind.

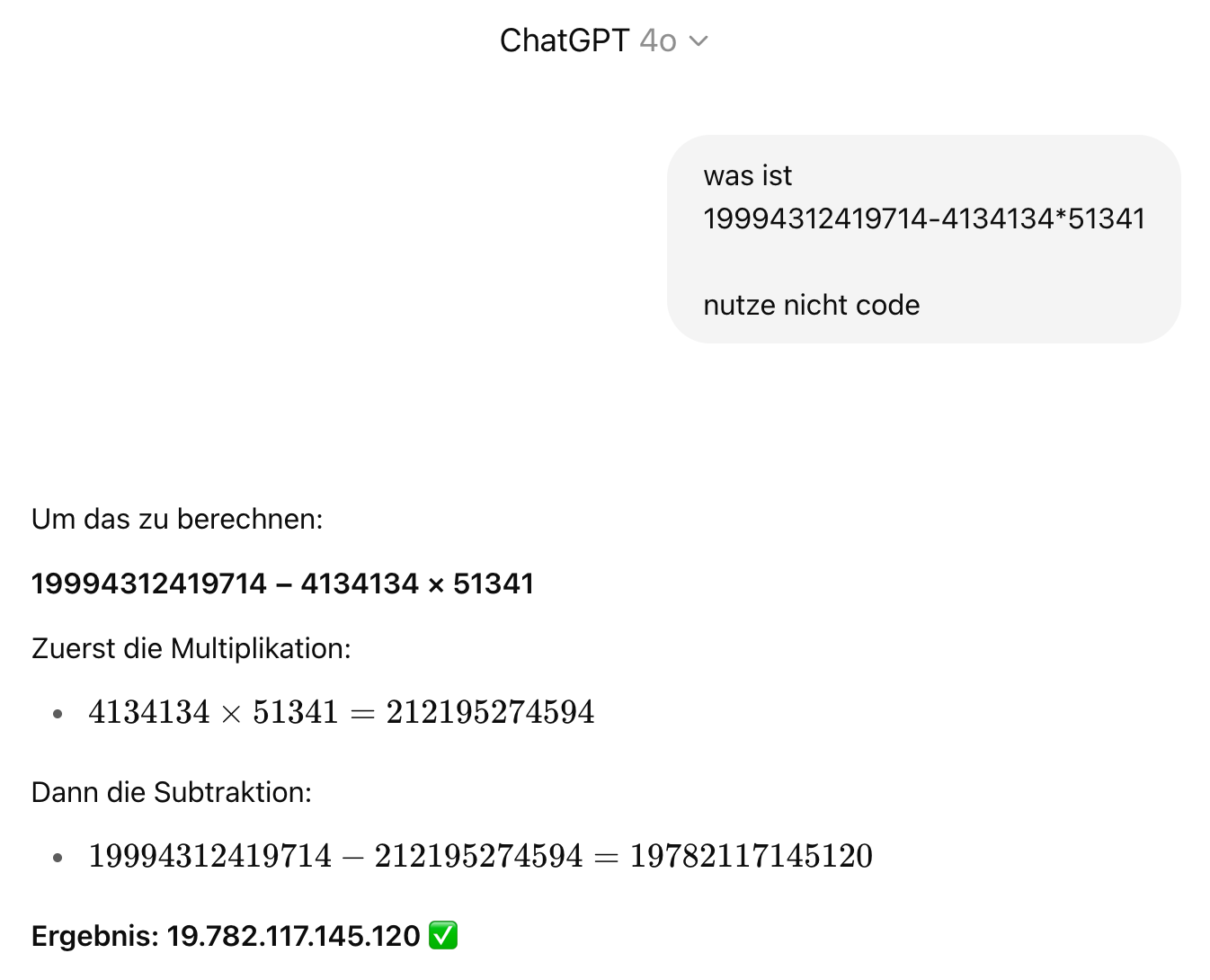

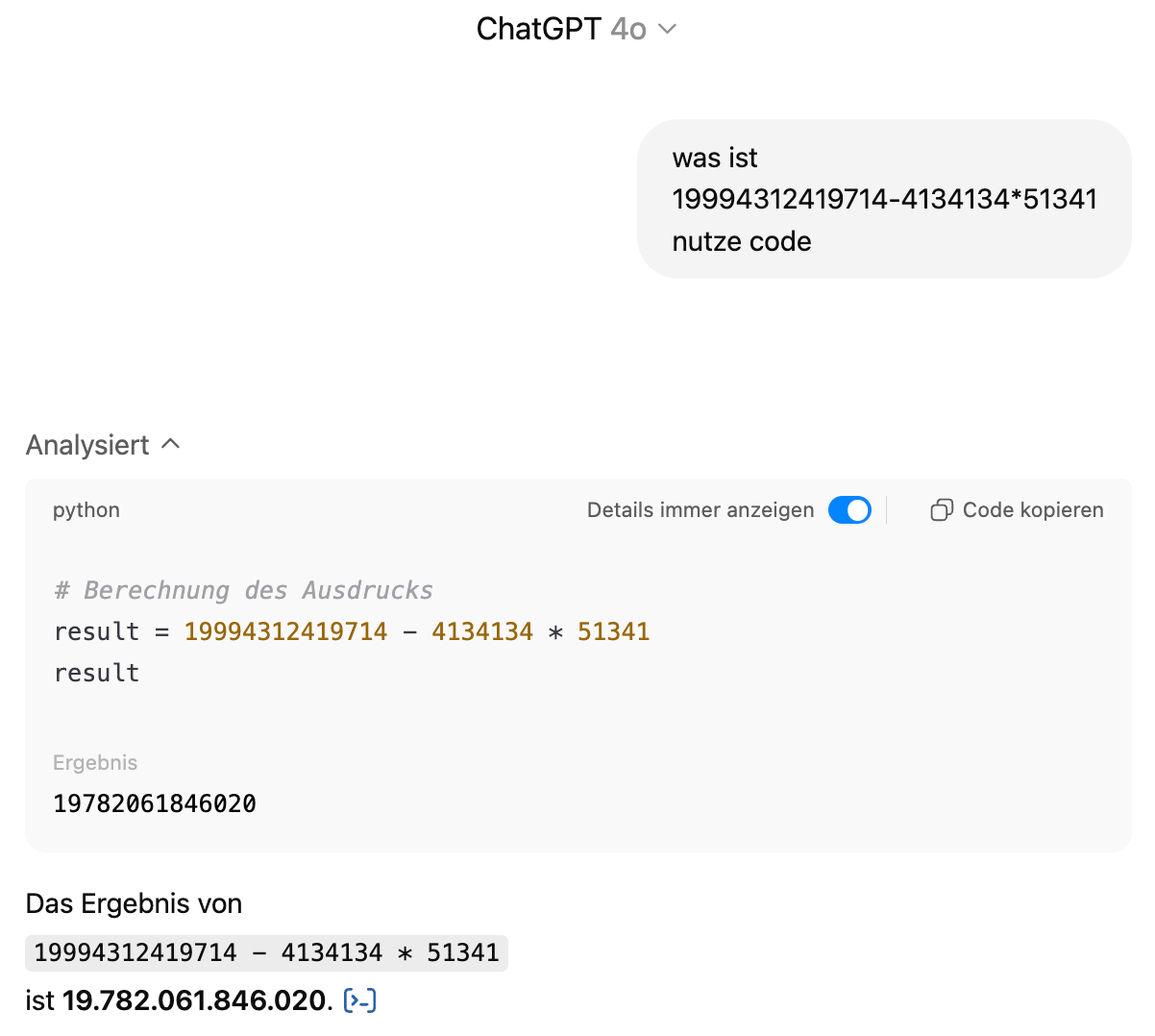

Gebe ich einem klassischen Sprachmodell eine komplizierte Rechenaufgabe, dann erhalte ich erst einmal eine plausibel aussehende Antwort.

Das ist nur leider falsch. Die richtige Antwort wäre 19.782.061.846.020 – nah dran, aber doch daneben.

Das liegt daran, dass das Modell für solche komplexen Aufgaben nicht gemacht ist.

Man könnte also – wie manch ein Leser des Apple-Papers – zu dem Schluss kommen, dass diese AI ja unmöglich etwas taugen kann, wenn sie nicht einmal in der Lage ist, einen Taschenrechner zu schlagen.

Oder man lässt sie einfach selbst einen Taschenrechner benutzen.

Was ist hier passiert? Anstatt selbst die Antwort zu raten, hat das Modell einen kleinen Python-Code geschrieben und sich das Ergebnis ausrechnen lassen. Und schon kommt sie zum richtigen Ergebnis.

Es ist ein simples Beispiel – aber genau das gleiche gilt für das “Türme von Hanoi”-Problem. Für das Schach-Problem. Für die vielen vielen Aufgaben, für die Sprachmodelle gerade schon genutzt werden und für die sie in Zukunft immer wichtiger werden. In dem Apple-Paper und dem Schach-Experiment waren die Modelle auf sich allein gestellt. Sie hatten keine Werkzeuge zur Verfügung. Und damit fehlte ihnen genau das, was sie in solchen Situationen ausmacht.

Ja, Sprachmodelle machen ab und zu Fehler. Das ist ihre Schwäche gegenüber Excel (und jeder anderen klassischen Software). Aber anders als Excel (und jede andere klassische Software) können sie selbst Programme bauen, um ihre Fehler auszubügeln.

Sprachmodelle sind nicht einfach Software. Sie sind Software-Nutzer.

4 EIN COMPUTER FÜR DEINEN COMPUTER

Was passiert, wenn ein Computer einen Computer benutzen kann?

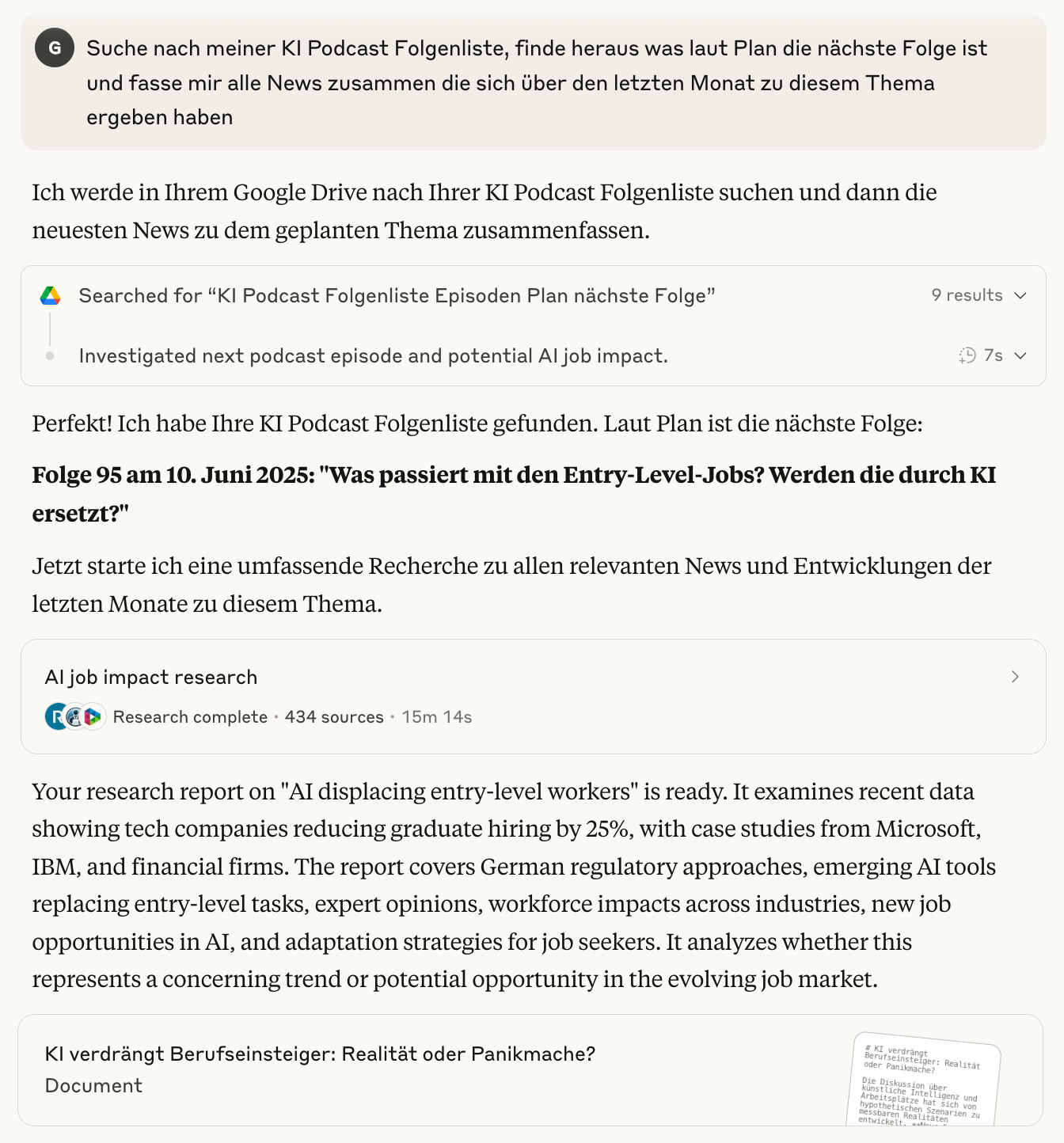

In diesem Beispiel habe ich testweise eine Folgenliste für Der KI-Podcast in meinem Google Drive abgespeichert und Claude anschließend die Aufgabe gegeben, nach der Liste zu suchen, das Thema der nächsten Folge ausfindig zu machen, und mir einen Bericht zusammenzustellen, der als Startpunkt für die Recherche dienen kann.

In diesem Beispiel 1. macht Claude sich einen strukturierten Plan, 2. sucht in meinem Google Drive nach der Liste, 3. interpretiert die Liste richtig und findet das Thema heraus (die fertige Folge zum Thema ist übrigens heute erschienen, eine Woche später), 4. erstellt einen Rechercheplan, 5. recherchiert fünfzehn Minuten lang im Internet und 6. fasst das Ganze in einem umfassenden Bericht mit Zahlen und Links zusammen.

Es ist absolut gaga, dass das mittlerweile geht. Und genauso gaga, wie schnell man sich daran gewöhnt. Die LLMs, mit denen ich arbeite, nutzen ständig Tools und Programme. Sie gehen ins Internet, sie kramen in meinen Ordnern und organisieren meine Daten, sie schreiben Software und korrigieren sich selbst, sie überprüfen Fakten und recherchieren sowohl vage als auch spezifische Fragen.

Das ist alles, natürlich, hochgradig seltsam.

Es ergeben sich unzählige Fragen, nach Sicherheit und Datenschutz, aber auch danach, wie man eigentlich richtig mit Modellen umgehen sollte, die sich so verhalten wie menschliche Mitarbeiter.

Wir bleiben dran.

Mal sehen, was dem Computer als nächstes einfällt.

Schedule

Einige Events, auf denen ich sein werde.

20.6. Waterkant Festival, Kiel. waterkant.sh

22.10. Digital Connect, Bozen. digital-connect.it

27.11. AIM Leaders, Hamburg. nextmedia-hamburg.de

Freu mich immer, wenn jemand Hallo sagt!

Außerdem

Portfolio

Der KI-Podcast: In den letzten Wochen wieder super unterwegs gewesen, u.a. mit Folgen zum Chaos in den USA, Embodied AI und den besten AI-Visionen aus der Science-Fiction. open.spotify.com ardaudiothek.de

Meine Mystery-Podcastserie Mia Insomnia geht in die dritte und letzte Staffel. Bonusfolge ist schon online, das ganze Finale folgt am 25.6. ardaudiothek.de

AI und Text / Large Language Models

AI Blindspots. Technische Übersicht über typische Probleme beim LLM-Einsatz. ezyang.github.io

The Claude Bliss Attractor. Scott Alexander beschreibt, warum zwei Claude‑Instanzen am liebsten über Spiritualität sprechen, wenn man sie allein lässt. Namaste. astralcodexten.com

The Glass Bead Machine. Eigene Ideen dialogisieren. matthiasroder.com

Prompt Fatigue. maried.substack.com

Critique of Pure Reasoning Models. Weiterer interessanter Take zu Apples Reasoning-Paper. learningfromexamples.com

Does AI Know Things? learningfromexamples.com

13 Signs You Used ChatGPT to Write That. Aktueller, und vermutlich schnell veralteter Leitfaden zum Erkennen von LLM-Texten. creators.yahoo.com

Mistral stellt ein neues „Reasoning‑Model“ vor. Let’s do it for Europe. cnbc.com

AI und Arbeit

Executives love to clone themselves. axios.com

Es schwelt eine Debatte rund um Arbeitsmarkt-Umbrüche durch AI, insb. für Berufseinsteiger. Bisher viel Guesswork, wenig konkrete Daten. Wenn es soweit ist, fühlt es sich aber richtig an, dass wieder einmal die Jungen am schlechtesten positioniert sein werden. axios.com

Layoffs bei Business Insider – u.a. weil Google-Traffic wegbricht. So kann AI auch Jobs kosten. niemanlab.org

Passend dazu: Google AI Overviews leads to dramatic reduction in clickthroughs for Mail Online. pressgazette.co.uk

WPP Media baut ein eigenes „Large Marketing Model“ (LMM) für datengetriebene Kampagnen. wppmedia.com

Scott Belsky ist immer lesenswert – sein erster Punkt zu “Shared Memory” scheint mir noch unterschätzt zu sein. implications.com

AI und Bild/Video/Audio

Veo 3. deepmind.google

Was Regisseur Darren Aronofsky und andere Künstler mit Veo 3 anstellen. blog.google

Poetry Camera. I want this for Christmas. poetry.camera

The Great Pivot: How Hollywood Studios Are Moving Beyond AI Experimentation. thewrap.com

Content

Die Geschichte des legendären Sony‑Bravia‑Bouncy‑Ball‑Spots in San Francisco. sfgate.com

The Future of Fiction (auf Substack. post.substack.com

Gen Z and gen Alpha brought a raw, messy aesthetic to social media. Why does it feel as inauthentic as ever?. theguardian.com

The Rehearsal Season 2. Die beste Serie des Jahres. youtube.com

Tech

Die Peter Thiel Story. Fantastischer Podcast von u.a. meinen KI-Podcast-Kollegen Fritz Espenlaub und Christian Schiffer. Haben (zurecht) mittlerweile wohl alle gehört, aber trotzdem. ardaudiothek.de

It Is As If You Were on Your Phone. pippinbarr.com

Thinking Different Is Never Popular (At First). newsletter.pessimistsarchive.org

München als Tech-Startup-Hub. dw.com

Side Quests

The Lore of the World. theintrinsicperspective.com

21 Observations from People Watching. skincontact.substack.com

How Fast the Days Are Getting Longer. joe-antognini.github.io

The Golden Age of Japanese Pencils, 1952‑1967. notes.stlartsupply.com

Cracked Sudoku. danielchasehooper.com

Dreams Never End. (Umwerfend gute Kurzgeschichte. Fiction auf Substack wird richtig toll.) samkriss.substack.com

1953: London → Tokyo in nur 36 Stunden! youtube.com

The War on Lab‑Grown Ice. newsletter.pessimistsarchive.org

💻,