Die letzten Trainingsdaten

Das Web ist nicht genug

hi! hier ist gregor schmalzrieds newsletter über künstliche intelligenz.

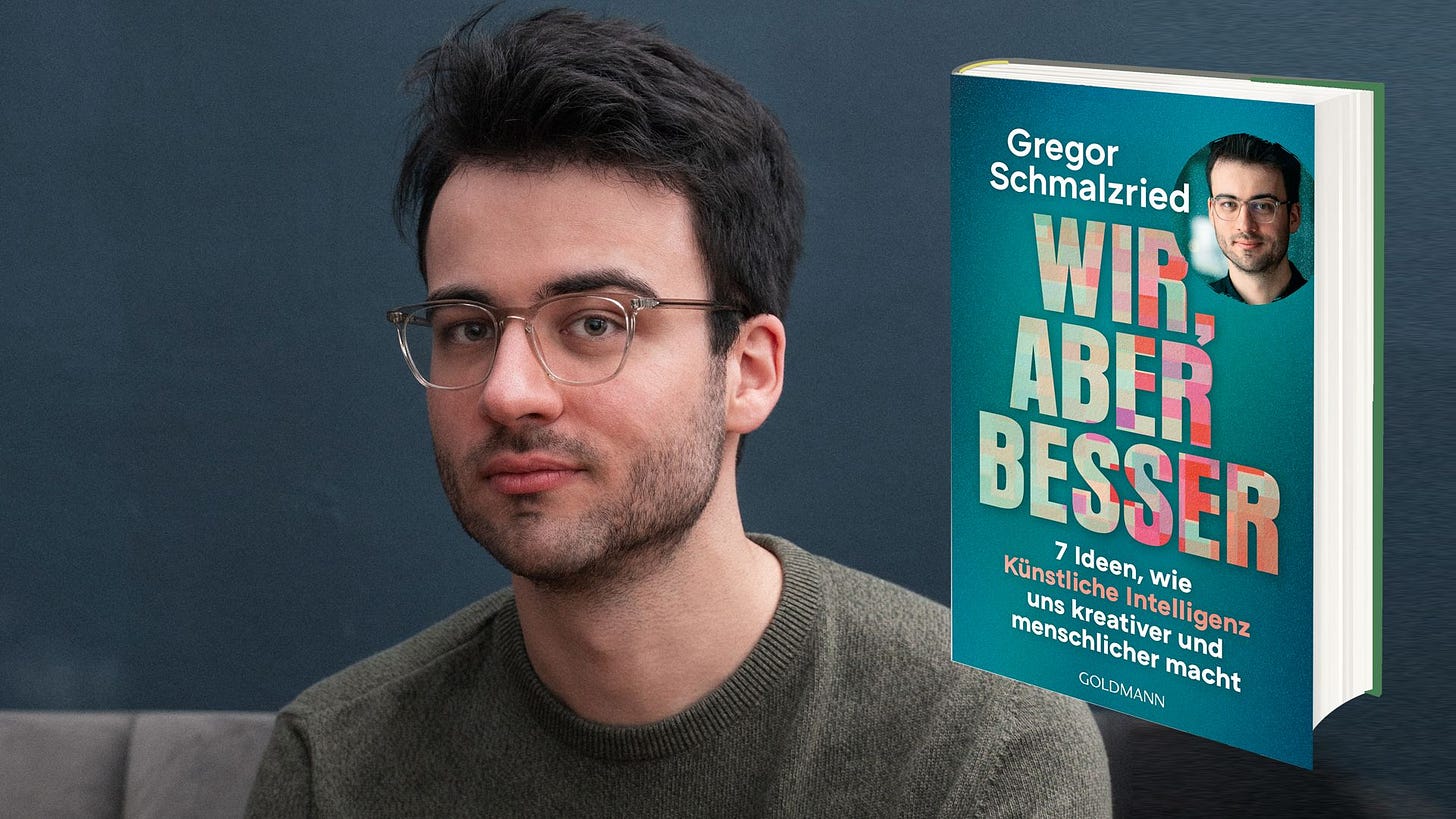

ich bin freiberuflicher journalist, berater, speaker und host von der ki-podcast (ARD)

Mein Sachbuch Wir, aber besser erscheint im November 2025 als Paperback, E-Book und Hörbuchdownload.

Für alle, die die AI-Zukunft kennenlernen wollen – und sich vielleicht sogar darauf freuen. Auch eine gute Weihnachtsgeschenk-Idee!

Link zu Amazon

Link zur Verlagsseite bei Penguin Random House

Die letzten Trainingsdaten

Generative AI ist gut im Nachbauen von dem, was sie in den Trainingsdaten gesehen hat.

So weit, so offensichtlich. Aber hinter dieser einfachen Wahrheit steckt eine faszinierende Erkenntnis über die Grenzen aktueller Modelle – und darüber, wie diese in Zukunft überwunden werden könnten.

1 ARBEIT ALS SIMULATION

Was ist das Problem mit dieser Antwort von GPT-5 Instant?

Auf den ersten Blick gar nichts. ChatGPTs Antwort sieht aus wie ein typischer Bericht zu der gestellten Frage. Sie geht auf verschiedene Punkte ein, liefert Beispiele und Empfehlungen.

Das Problem zeigt sich beim zweiten Blick.

Wenn man die Antwort des Bots genauer untersucht (Link zum ganzen Gespräch hier), stellt man fest: Der Text folgt zwar der Form eines Berichts, in den ausführliche Recherchen geflossen sind. Aber sobald man die Form beiseite lässt, fehlt alles, was einen solchen Bericht in der Realität auszeichnen würde: Echte inhaltliche Arbeit, eine echte Auseinandersetzung, echte Erkenntnisse. Obwohl die AI Marktlücken identifizieren sollte, schlägt sie nur Allgemeinplätze vor – die vielleicht plausibel klingen, aber in der Realität überhaupt nicht weiterhelfen.

Diese Antwort ist deshalb keine wirkliche Leistung. Sie ist “Workslop”. Leere Kalorien. Eine Token-Beschaffungsmaßnahme, die Arbeit vortäuscht, aber nicht wirklich unterstützt – oder gar ersetzt.

Wer in der Wissensarbeit mit Sprachmodellen arbeitet, der stößt immer wieder auf solche Fälle: Die AI liefert uns Texte, die aussehen wie eine Lösung, ohne wirklich eine zu sein: Kampagnen-Pläne, die sich auf irrelevante USPs beziehen. Juristische Einschätzungen, die überzeugend klingen, aber nicht wirklich anwendbar sind. Daten-Analysen, die wichtige Zahlen durcheinanderbringen. Dienstpläne, die Personen doppelt besetzen.

Man bekommt dieses Problem zum Teil dadurch in den Griff, dass man die richtigen Modelle einsetzt. Moderne “Reasoning”-Modelle wie GPT-5 Thinking sind deutlich besser darin, sich selbst zu hinterfragen und komplexeren Prozessen zu folgen. Auch die Frage nach der KI-Podcast-Marktlücke beantwortet GPT-5 Thinking mit einem guten Prompt sehr viel vernünftiger als seine Nicht-Reasoning-Schwester im Screenshot weiter oben (Link zur ganzen Antwort):

Aber die Herausforderung ist damit noch nicht gelöst. Auch Reasoning-Modelle sind weit davon entfernt, komplexe menschliche Arbeitsprozesse zu übernehmen.

Der “Remote Labor Index” ist eine neue Benchmark-Messung, die untersucht, wie gut aktuelle KI-Modelle im autonomen Übernehmen von Remote-Arbeit sind – etwa im Produktdesign, in der Audioproduktion und im Erstellen von wissenschaftlichen Dokumenten. Aktueller Stand: Der beste AI-Agent erledigt nur 2,5 Prozent der Aufgaben auf Menschenniveau. Trotz Reasoning.

Etwas anekdotischer, aber dafür unterhaltsamer ist das Experiment der “Agent Company”, in der verschiedene AI-Modelle die Rollen von Mitarbeitern in einem fiktiven Unternehmen übernehmen sollen. Das Ergebnis: Chaos. Als eine der AIs eine Zielperson nicht im System finden konnte, benannte sie einfach eine andere Person in den Namen ihrer Zielperson um – und schrieb dieser die Nachricht.

All das heißt nicht, dass Generative AI bei der Arbeit nutzlos ist. Aber es heißt, dass Generative AI aktuell autonom nicht in der Lage ist, menschliche Prozesse nachzubilden.

Diese Tatsache fühlt sich manchmal eigenartig an. Wieso leben wir in einer Zeit, in der AI zwar menschlich klingende Texte schreiben, real aussehende Videos erzeugen und emotional anmutende Gespräche führen kann… aber an den einfachsten Arbeitsprozessen scheitert?

Wie Comedian Fabi Rommel es in diesem Sketch zusammenfasst: “Kannst du mir wenigstens irgendeine Bürokratieaufgabe abnehmen, bevor du die Welt zerstörst?”

Natürlich hilft AI heute schon massiv bei Bürokratieaufgaben. Aber nur, wenn man Zeit ins Onboarding investiert (siehe “Der große Trenner”).

Auf sich gestellt, mit Bordmitteln, kann Generative AI eben nur das, was sie in ihren Trainingsdaten hat: Bilder erstellen. Texte erstellen. Videos erstellen.

Aber Bilder, Texte und Videos sind für die meisten von uns nicht das Ziel. Arbeit ist das Ziel. Und hier tut sie sich schwerer.

Ein Sprachmodell könnte mir zwar auf Anhieb eine perfekt aussehende Steuererklärung erzeugen. Nur… dass die Zahlen und Daten sich korrekt auf die von mir gesammelten Rechnungen beziehen, das ist die eigentliche Herausforderung.

Hier werden die Trainingsdaten zum Problem:

Sprachmodelle kennen fertige Steuererklärungen. Aber sie kennen es nicht, eine Steuererklärung auszufüllen. Sie kennen interne Nachrichten unter Kollegen. Aber sie kennen nicht die Prozesse innerhalb des Unternehmens, die zu diesen Nachrichten geführt haben.

Die eigentliche Arbeit, die wir Menschen machen, liegt eben nicht in den fertigen Texten, Dokumenten und Dateien. Sie liegt in den Schritten davor.

Der Prozess ist die Arbeit. Das Ergebnis ist nur die Kommunikation dieser Arbeit.

Genau diesen Unterschied verstehen moderne AI-Modelle oft nicht. Sie kommunizieren deshalb immer wieder Arbeit, die sie gar nicht gemacht haben. Für sie ist es egal, ob sie die richtige Zielperson angeschrieben haben oder eine andere, die sie zur Zielperson umbenannt haben. Die Kommunikation einer Sache ist für sie identisch mit der Sache selbst.

Sobald wir das verstehen, verstehen wir auch die Grenzen moderner KI-Systeme. Wir verstehen besser, warum sie halluzinieren. Warum sie so schlecht darin sind, ihre eigenen Fähigkeiten einzuschätzen. Und warum sie so menschlich klingen – obwohl sie unter der Haube völlig anders funktionieren.

Wir verstehen aber auch, wie man diese Grenzen überwinden könnte:

Wenn das Problem die Trainingsdaten sind… könnte man dann nicht einfach dort ansetzen?

Die KI nicht mehr nur mit fertigen Berichten, Steuererklärungen und Slack-Nachrichten trainieren? Sondern mit menschlicher Arbeit?

We’re about to find out.

2 ARBEIT ALS ARBEIT

Zwei – scheinbar zusammenhanglose – News-Storys der letzten Monate.

Anfang Oktober meldet Bloomberg, dass ein Data-Labeling-Startup namens Mercor über hundert ehemalige Investment-Banker rekrutiert hat, um für OpenAI AI-Modelle zu trainieren. Die Ex-Banker sollen Finanzmodelle für Restrukturierungen, Börsengänge und M&A-Deals erstellen und der AI beibringen, wie man diese Aufgaben ausführt. Eine Woche später die nächste Meldung: Das gleiche Startup hat fast 150 ehemalige Berater von McKinsey, BCG und Bain unter Vertrag genommen. Diesmal für Unternehmensberatung statt Investment Banking. Die Ex-Consultants sollen AI-Modellen wie Google Gemini beibringen, die Entry-Level-Aufgaben ihrer alten Branche zu übernehmen, also wie man einen Case analysiert und wie man von der Aufgabenstellung zur Lösung kommt.

Der neue Haushaltsroboter “NEO” des Startups 1X soll Haushaltsaufgaben übernehmen: Müll rausbringen, Zimmer aufräumen. Aber NEO kann das noch nicht wirklich alleine. Für komplexere Aufgaben braucht der Roboter menschliche “Teleoperatoren” – Mitarbeiter von 1X, die durch die Augen des Roboters in dein Zuhause schauen und ihm zeigen, wie man eine Aufgabe erledigt. Die Kalkulation bei 1X: Durch diese Remote-Arbeit sollen die Trainingsdaten gesammeln werden, die NEO braucht, um irgendwann ganz alleine die Spülmaschine einzuräumen.

Die Generative AI, die wir kennen, war ein Nebenbei-Produkt des Internets. Sie basiert auf den Daten, die zufällig zur Verfügung standen – nicht auf denen, die explizit für sie geschaffen wurden. Aber jetzt, wo wir die Trainings-Mechanismen besser verstehen, werden die gleichen Prinzipien auch auf andere Datensammlungen angewandt. Diese müssen nur erst einmal aufgebaut werden.

Die Initiativen von Mercor und 1X sind dabei nur die aktuellsten Kapitel einer Geschichte, die schon seit Jahren läuft: Menschliche Arbeit in Tokens zu verwandeln, mit denen ein AI-Modell etwas anfangen kann.

Das erste Zwischenergebnis dieser Operation sind agentische “Computer Use”-Modelle wie der ChatGPT “Agent Mode” und AI-Browser wie Comet und Atlas. Die haben gerade noch einige Kinderkrankheiten (siehe Der KI-Podcast: Sollten wir alle auf KI-Browser wechseln?”). Aber das hatte GPT-3 vor ein paar Jahren auch noch.

Gleichzeitig sind agentische Systeme in abgeschlossenen Software-Umgebungen wie Notion und Asana in den letzten Monaten erstaunlich gut geworden.

Es hat ein paar Jahre gedauert. Aber die Vorstellung einer AI, die auch diffuse menschliche Arbeit als Prozess versteht, wird immer klarer umrissen.

3 WORK FINDS A WAY

Arbeit mit AI fühlt sich heute schon futuristisch an. Ich erlebe jeden Monat neue Erfolgsmomente, die noch vor Kurzem unmöglich gewesen wären. (Claude kann jetzt Powerpoints!)

In der absehbaren Zukunft wird AI vor allem denjenigen helfen, die diese Fähigkeiten nutzen, klar von menschlichen Fähigkeiten abtrennen und ihre Prozesse teilweise rund um die Technologie umstrukturieren: Man formatiert Excel-Sheets anders, damit das Sprachmodell sie besser versteht. Man verschickt Angebote in neuen Formaten, weil das Sprachmodell diese robuster ausgibt.

Nur… was passiert, wenn nicht mehr nur der Output als Trainingsdaten eingelesen sind, sondern der ganze Prozess auf dem Weg dort? Was, wenn die AI nicht nur Arbeit simulieren, sondern wirklich verrichten kann?

Wir wissen noch nicht, ob das wirklich funktionieren kann und die Wette der Tech-Unternehmen in dieser Form aufgeht. Ich halte es für gut möglich, dass uns hier enorme Sprünge bevorstehen. Aber menschliche Arbeit ist mehr als nur das Herumtippen auf Tastatur und Maus. Selbst ein Computer-Gehirn-Interface wäre nicht in der Lage, all das zu erfassen, was unsere kognitive Leistung ausmacht.

Und wenn das doch irgendwie funktioniert… Selbst dann glaube ich nicht, dass wir alle arbeitslos werden.

Eine beliebte Definition von AGI ist “AI, die jede wirtschaftlich wertvolle Arbeit übernehmen kann”.

Doch in dem Moment, in dem eine AI eine Arbeit erledigen kann, ist diese eben deutlich weniger wirtschaftlich wertvoll als vorher. Das bedeutet, der Wert weicht aus… woanders hin. Und dem folgen wir. Wir Menschen waren schon immer Meister darin, neue Bottlenecks und Herausforderungen zu finden.

Arbeit findet immer ihren Weg.

Mein Sachbuch Wir, aber besser erscheint im November 2025 als Paperback, E-Book und Hörbuchdownload.

Link zu Amazon

Link zur Verlagsseite bei Penguin Random House

AT FREIBURG UND UMGEBUNG:

Am 25.11.2025 lese ich in der Buchhandlung Rombach, Freiburg aus meinem Buch und mache zusätzlich ein kleines interaktives Programm.

Ich freu mich übers Vorbeischauen!

mehr info hier

Außerdem

Portfolio

Der KI-Podcast (ARD) – der wöchentliche Podcast von Fritz, Marie und mir auf Spotify. open.spotify.com Mit aktuellen Folgen zur Zukunft des Internets und KI-gestützter Forschung.

Der KI-Podcast (ARD) – der wöchentliche Podcast von Fritz, Marie und mir in der ARD Audiothek. ardaudiothek.de

Ich war kurz zu Gast in einer unterhaltsamen und interessanten Marktcheck-Reportage zur Frage: “Kann man mit KI-Influencern reich werden?” youtube.com

AI und Text / Sprachmodelle

KI-Panne beim Spiegel. Ist das Journalismus? linkedin.com

The first-ever cash poker tournament for LLMs. pokerbattle.ai

Where have the really big AI models gone? (Headline: GPT-5 wurde vermutlich mit weniger Ressourcen trainiert als GPT-4.5. Einfach weil die Ressourcen für Inferenz gebraucht wurden. Mal schauen, was passiert, wenn die Rechenzentren in den USA weiter ausgebaut werden. transformernews.ai

3 New AI Scams You Need To Prepare For. decision.substack.com

AI Friends Too Cheap To Meter. jasmi.news

Emergent Introspective Awareness in Large Language Models. Hoch-faszinierender und wenig verlässlicher Research von Anthropic. transformer-circuits.pub

AI und Arbeit

AI cyberrisk might be a bit overhyped — for now at least. transformernews.ai

Audits, not essays: How to win trust for enterprise AI. transformernews.ai

Japan’s unusual approach to AI policy. transformernews.ai

AI und alles andere

“Deep Dream”. Metamoderne AI-Kunst, wirklich gut und spooky (finde ich). Mit Ohrwurm-Song. youtube.com

China bets on Europe for self-driving tech expansion. reuters.com

How a Gemma model helped discover a new potential cancer therapy pathway. blog.google

The AI water issue is fake. andymasley.substack.com

16 charts that explain the AI boom. understandingai.org

Content

Die Grenzen zwischen Audio, Video und Podcast verschwimmen. beifahrersitz.substack.com

Why Netflix Struggles To Make Good Movies. statsignificant.com

Todd in the Shadows, YouTubes bester Pop-Kritiker, über Taylor Swifts “The Fate of Ophelia”. youtube.com

Tech

What Happened to Apple’s Legendary Attention to Detail? blog.johnozbay.com

The Lottery-fication of Everything. dopaminemarkets.com

Culture

I Feel Sad about Emma Stone’s New Face. katelynbeaty.substack.com

The Modern Subject No Longer Exists. auerstack.substack.com

Side Quests

Deutsche Betriebe haben in den vergangenen drei Jahren rund 325.000 Arbeitskräfte zusätzlich eingestellt, um die gestiegene Bürokratie zu bewältigen. Vielleicht dachte der Gesetzgeber, dass AI das alles erledigt. heise.de

World Map according to Fish. southernwoodenboatsailing.com

Space Elevator. neal.fun

Of Monsters and Men – Fruit Bat (Live from Skarkali). Song of the year? youtube.com

⌨️,